Однією з найчастіших проблем, що заважають SEO-просуванню, є дублі сторінок. Вони містять однаковий з оригіналом зміст, але при цьому вони відрізняються URL. Чому вони виникають, як їх шукати – читайте у цій статті.

Що таке дубльований контент та його види

Під цим терміном мається на увазі ідентичне наповнення сторінок із різними урлами. Дубльований контент може бути розташований як на одному, так і на кількох доменних іменах. З'являються вони не лише через копіювання вмісту. Дублі сторінок також виникають внаслідок неможливості виключення тестової версії сайту з індексації або невиконаної переадресації.

Залежно від обсягу скопійованого контенту їх поділяють на:

- повні;

- часткові.

Перші містять 100% ідентичного матеріалу. Зазвичай до повних належать дзеркала ресурсів, адреса яких може містити або не містити www, дублі main page та реферальних програм. Ще сюди відносяться веб-сторінки, пов'язані з некоректною ієрархією, що містять в URL численні символи // або ///. Виникають повні дублі та через неправильно виконаний переїзд на протокол SSL. Їх обов'язково потрібно видалити і якнайшвидше.

Часткові дублюють контент не повністю, а лише якусь його частину. Це web-сторінки пагінації, сортування. Найчастіше їхнє виникнення зумовлене нюансами CMS. Дізнатися такі можна за параметром get. До часткових дублів можуть належати й інші типи сторінок: відгуків, властивостей товару, фільтрації чи копії, створені за допомогою AJAX.

Проблеми внутрішнього та зовнішнього дублювання

Особливість сторінок з ідентичним змістом у тому, що вони можуть виникати не лише на якомусь одному сайті, а й одразу на кількох. Називаються вони, відповідно, внутрішніми та зовнішніми. Зупинимося на нюансах докладніше.

Внутрішнє дублювання

Так називають сторінки, що містять ідентичне наповнення, розташовані на одному ресурсі, але за різними адресами.

Внутрішнє дублювання призводить до канібалізації фраз. При такій ситуації щонайменше пара підсторінок одного доменного імені може відображатися для одного ключа.

Якщо внутрішнє дублювання не усунути, позиції почнуть «стрибати» у видачі. Чому? Все просто – якщо є дублювання контенту на сайті, пошукова система не зможе визначити, яку зі сторінок показати, тому демонструватимуться вони по черзі. Через це алгоритми Google розцінять їх як неякісні, і пріоритет у ранжируванні надаватиметься іншим сайтам.

Рекомендуємо також почитати про те, як виконується просування сайту, та принципи ранжування.

Бажаєте отримати комплексний аналіз вашого сайту?

Зовнішнє дублювання

Так називають ідентичний контент, розташований на різних веб-ресурсах. Трапляється таке в основному з двох причин:

- крадіжка;

- розміщення контенту копії зі свого сайту на інших майданчиках.

Дублі сторінок у піддоменах теж належать до цієї категорії. Якщо ж однаковий текст розміщено на кількох доменних іменах, то пошуковик Google на високій позиції відображатиме ту сторінку, оптимізація якої виконана краще, створена раніше або лінк на неї розміщений на великій кількості донорів.

Причини внутрішнього дублювання

Розглянемо причини, які найчастіше призводять до проблеми. Це важливо, оскільки таке дублювання контенту на сайті відбувається буквально у кожного власника ресурсу. Щоб зрозуміти, чому так сталося і як перевірити дублі сторінок сайту, читайте далі.

Дубль товару з різних URL

Варіанти продукту, які розміщені на кількох підсторінках – явище нерідке. Якби постійно використовувалися унікальні описи, проблема не виникла. Але далеко не завжди дотримується цього правила, особливо якщо у продажу є багато позицій товару з невеликими відмінностями (модель туфель у різних кольорах, наприклад) і витрачатися на оригінальні описи немає часу та зайвих коштів. Це, до речі, один із найчастіших прийомів маркетингу. Через такий підхід і виникає дублювання контенту на сайті, що спричиняє проблеми з просуванням.

Залишати ситуацію так не можна, треба усунути проблему і перевірити дублі сторінок. Це необхідно, щоб інтернет-ресурс не втратив позиції у рейтингу.

Пошук дубльованих сторінок

Як знайти дублі сторінок і чи моожливо це? По-перше, можливо, а по-друге, способів є декілька. Розкажемо докладніше, як знайти дублі сторінок на сайті.

За допомогою спеціальних програм та сервісів

Виявити дублі сторінок можна за допомогою:

- Xenu;

- NetPeak Spider;

- Screaming Frog SEO Spider.

Ці та подібні до них програми знаходять веб-сторінки з ідентичним вмістом, перевіряючи збіг метатегів.

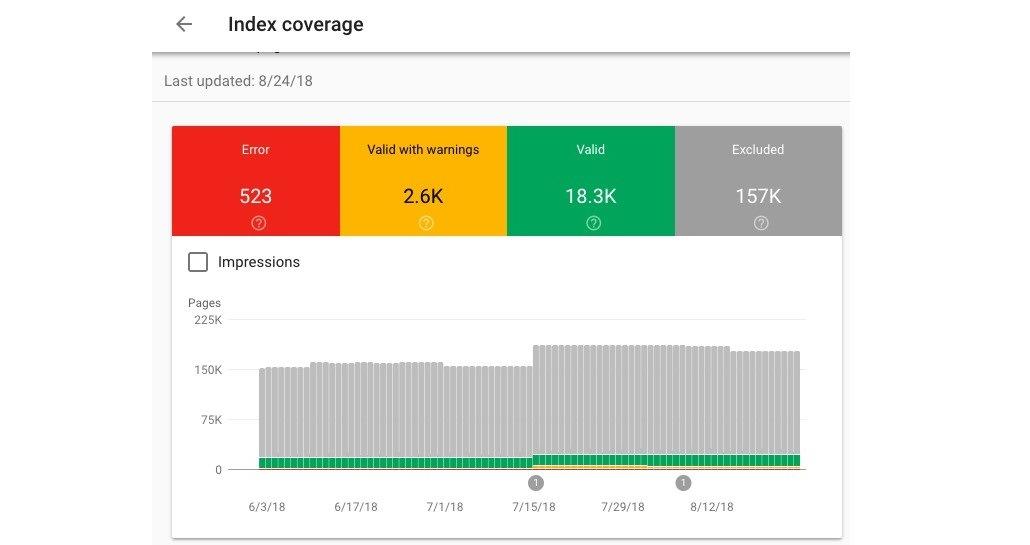

Ще пошук дублів сторінок можна виконувати через інструмент Google Search Console. Він допоможе виявити на сайті дублі та дасть рекомендації, як їх усунути.

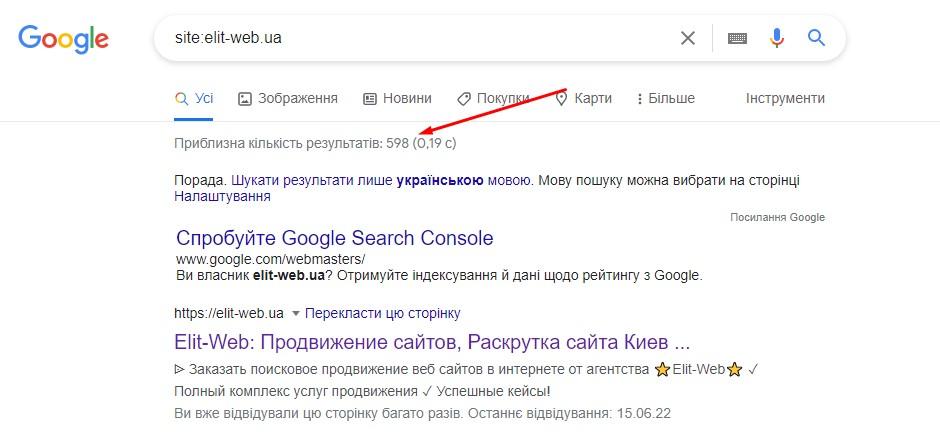

Використання пошукових операторів

До таких відносяться "inurl" та "site". Оператори аналізують URL і при виявленні адрес з однаковим контентом видають їх списком.

Як знайти дублі сторінок за допомогою пошукових операторів? Потрібно просто в полі пошуку запровадити оператора перед адресою сайту. Наприклад:

site:https:// назва ресурсу.com - site:https:// назва ресурсу.com/&

У цій формулі перше визначення показує сторінки вашого веб-ресурсу, які містяться в загальному індексі Google. Друге – сторінки, які задіяні у пошуку.

Як боротися з проблемою дублювання контенту

Буває, що писати унікальні тексти для однотипних товарів не завжди має можливість. Але й дублювання контенту не вихід. Уникнути проблеми допоможе спеціальний тег, що веде до базової версії - rel = canonical. Таке посилання вказує роботам пошукової системи переважні сторінки для підсторінок схожого типу. Вдаватися до нього потрібно, якщо тексти повторюються на кількох урлах.

Ще один спосіб, який допоможе уникнути такої проблеми, як дубльований контент – створювати на схожі товари унікальні картки із опцією вибору потрібного варіанту. Але слід врахувати, щоб за такого підходу URL не змінювався. Інші підсторінки потрібно перенаправити на головну.

Якщо на кожен тип товару вже підібрані ключі та створено контент, необхідно створити індивідуальні адреси URL. Таким чином, вдасться досягти оптимізації товару під відмінні риси, що покращить видимість у видачі. Ключі з хвостами допоможуть залучити більшу кількість клієнтів – потенційних, що відбулися або потенційних.

Сайт доступний за багатьма адресами

Причин такого явища є досить багато. Серед найпоширеніших:

- Індексування тест-версії ресурсу . Процес створення або редагування наявного сайту спричиняє появу версії, яка при правильному розкладі повинна залишатися доступною лише розробникам. Але якщо від індексації вона не прихована, то робот просканує її, в результаті з'являться дублі сторінок на сайті.

- Відображення home page відразу по кількох урлах . Деякі з движків можуть створювати адреси в різних версіях з невеликими відмінностями в написанні: зі слішем або без, з index.php або index.html. Подібне вказує на те, що однакові тексти відображаються на декількох сторінках, виникає дублювання контенту. Такого результату можна уникнути, якщо вказати пошуковій системі на оригінал сайту, перенаправивши на нього адреси-копії.

- Неправильне підключення стандарту SSL . Дублювання контенту на сайті може виникати і через відсутність редиректу. Його обов'язково слід настроїти підключенням SSL. Пошуковик сторінки http і https сприймає як різні, тобто вважатиме їх за дві версії ресурсу. Щоб не виникло дублів, слід виконати кілька дій:

- налаштувати редирект для підсторінок;

- видалити внутрішні посилання, що містять http без підключеного стандарту SSL. Зробити це можна, якщо перевірити канонічні посилання та файли з графічним зображенням;

- виконати оновлення sitemap.xml. Але перед цим слід створити файл на поточну адресу.

Ще потрібно подбати про додавання версії ресурсу з SSL до Search Controle пошукової системи Google, надіслати sitemap.xml оновленого типу.

Неоптимізовані сторінки сортування та фільтрації

Дублі сторінок на сайті ще можуть виникати і через неправильно виконану оптимізацію таких функцій, як фільтрація та сортування. Чому? Справа в тому, що налаштування даних функцій змінює лише певну частину ресурсу, ту, де розміщені товари. При цьому вміст не змінюється. А ось коли в процесі перезавантаження додаються параметри фільтру та сортування, то з'являються копії.

Вирішити цю проблему допоможе тег, який ми вже згадували – rel=canonical. Але навіть так сторінки відображатимуться у видачі. Щоб видалити їх, знадобиться метатег – noindex.

Можна ще подбати про те, щоб не відображався процес індексування фільтрації та сортування у robots.txt. Допомогти в цьому може директива, яка блокує доступ до рядка сторінок. Подібний метод також ефективно заощаджує бюджет, виділений на краулінг.

Але перш ніж застосовувати спосіб, слід перевірити, як він позначиться на трафіку, чи не впаде відвідуваність? Якщо знизиться, можна спробувати оптимізувати цю частину аудиторії під ключі з хвостами.

Внутрішній пошук та копії

Проблеми можуть виникати і через погану реалізацію опції пошуку на ресурсі. Її застосування часом провокує появу нової веб-сторінки, яка буде копією. Вирішити таку проблему можна додаванням у robots.txt кілька директив, що закривають доступ для роботів до сторінок внутрішнього пошуку.

Неоптимізовані сторінки пагінації

Пагінація допомагає розділяти вміст та розміщувати ці частини на підсторінках. Як контент можуть використовуватися список категорій, товари та ін.

Якщо пагінація виконана неправильно, вона супроводжується низкою проблем:

- копія першої сторінки;

- відсутність відмінності у заголовках тегів;

- ідентичне наповнення.

Працюючи над пагінацією, відразу треба моніторити, щоб не утворювалися дублі сторінок.

Неправильна реалізація мовних версій

Відсутність перекладів на кожній сторінці також є причиною дублів. Уникнути ризиків можна, якщо виконати переклад текстів мовою, яка відповідає країні просування. Ще допоможе вказівка на сторінках атрибутів hreflang. Так, пошукові системи зрозуміють, що на ресурсі реалізовано кілька мовних версій.

Як створюється зовнішнє дублювання

Такі ситуації не завжди виникають через крадіжки контенту. Причини можуть бути різними.

Копіювання описів товарів з сайтів виробників

Так званий копіпаст широко використовується. Але не все в курсі, що подібні методи спричиняють проблеми. Якщо є безліч товарів, і немає можливості для кожного створити унікальний контент, необхідно підготувати тексти хоча б для позицій, які визначені пріоритетними.

Оригінальність наповнення цінується пошуковими системами. Тому шанси піднятися в рейтингу ресурсу з унікальним контентом теж вищі.

Створення кількох схожих чи однакових сайтів

Дублі на сайті з'являються, якщо є субдомен. Так називають версії ресурсу, створені під певні регіони. Щоб не допускати появи дублів, при розробці субдоменів слід звернути увагу на написання нових текстів.

Висновки

Дублювання контенту на сайті – проблема поширена. Часом до її появи призводять несподівані чинники, тому важливо моніторити ресурс, щоб виявити їх якомога раніше та швидко усунути. Також слід вжити заходів щодо запобігання появі дублів. Для цього необхідно кожну сторінку наповнити корисним та унікальним контентом.

Ми, команда Elit-Web, при просуванні сайтів приділяємо особливу увагу цьому аспекту. Щоб знизити ризики створення дублів, веб-ресурс клієнта наповнюється лише унікальним оптимізованим контентом, який створюють наші автори. Відповідальний підхід до створення текстів дозволяє забезпечувати гарантований результат та успішне пошукове просування сайтів.

FAQ

Що робити з дублями сторінок на сайті?

Щоб позбутися дублів, можна використовувати один із таких способів:

- Встановити 301 редирект з однієї дублювальної сторінки на іншу, яка є канонічною.

- Додати у файл robots.txt директиву, яка вказує пошуковим системам ігнорувати незначущі GET-параметри у URL.

- Додати атрибут rel="canonical" у тегкожної дублювальної сторінки, який посилається на канонічну сторінку.

- Закрити дублювальні сторінки від індексації за допомогою метатегу <meta name="robots" content="noindex">.

Загалом, щоб запобігти появі дублів, важливо наповнювати сайт тільки унікальним контентом.

Що таке дублі сторінок на сайті?

Дублі сторінок на сайті — це сторінки, де подібна або повністю повторювана інформація доступна за різними URL-адресами. Вони можуть негативно впливати на SEO та ранжування ресурсу, а також приводити до бану від пошукових систем.

Чому з'являються дублі сторінок?

Дублі сторінок з'являються, коли один і той самий контент доступний за різними URL-адресами. Це може бути викликано різними причинами, наприклад:

- неуважністю адміністратора сайту, який випадково розмістив один і той самий матеріал у декількох місцях;

- технічними помилками, що призводять до некоректної генерації або налаштування посилань;

- особливостями системи керування контентом, яка може створювати дублі в різних розділах;

- неналаштоване головне дзеркало ресурсу або склейка домену, через що сайт доступний із www і без www, із http і https, з одним або декількома слешами в кінці.

Залишіть ваші контактні дані.

Будемо раді обговорити ваш проект!