Навіть новачки в SEO знають, що пошукові роботи Google засновують свою роботу на базі даних, до якої включено інформацію про мільйони сторінок. Це індекс результатів пошукової системи. Коли ви виконуєте пошук в Google, система переглядає свій індекс і виводить найбільш релевантні результати. У більшості випадків власники сайтів хочуть, щоб сторінки потрапили до індексу та з'являлися в результатах пошуку Google. Однак бувають випадки, коли виникає потреба заборонити індексувати сайт. У цій статті ми розповімо, як це зробити.

Чому іноді потрібно закрити сайт чи сторінку від індексації

Існують різні причини, щоб закрити сайт від пошукових систем. Наприклад, власники порталів або розробники приймають таке рішення, коли:

- небажано, щоб інформація просочилася в пошукову систему занадто рано, наприклад коли йдеться про нові послуги або продукт на етапі розробки;

- потрібно захистити конфіденційну інформацію. Наприклад, у випадку, якщо клієнт заповнює будь-які форми на сайті для замовлення послуги, важливо забезпечити, щоб персональні дані не стали об'єктом загального доступу;

- сторінка, де раніше був розміщений контент, фактично видалена, але інформація все ще знаходиться в індексі та може помилково відображатися у видачі;

- були виявлені дублі контенту, наприклад на сторінках з фільтрами товарів або категорії, що дублюються, а також неактуальна інформація (наприклад, про акції, що завершилися).

Від індексації зазвичай відключають службові сторінки, які не мають цінності для користувача.

Корисні поради, як закрити сайт від індексації

Ми пропонуємо кілька варіантів, як зробити, щоб сайт не індексувався.

За допомогою Robots.txt

Як відомо, доступ пошукових краулерів до сторінок і розділів вебресурсу забезпечує файл robots.txt. На підставі цього принципу цілком логічно припустити, що таким чином можна закрити сайт від індексації, robots txt у цьому випадку стане тим місцем, куди буде внесено зміни.

Щоб грамотно налаштувати систему дозволів та заборон для пошукових алгоритмів, корисно розуміти, що означають директиви у цьому файлі:

- user-agent — це свого роду звернення до роботів конкретної пошукової системи або до всіх роботів;

- disallow — команда, яка забороняє індексацію конкретних сторінок або розділів сайту;

- allow — директива з протилежним змістом. Вона дозволяє індексацію окремих сторінок чи розділів;

- sitemap — покажчик, котрий демонструє, які сторінки є на вебресурсі та як вони пов'язані між собою. Команда відкриває шлях до XML-картки сайту.

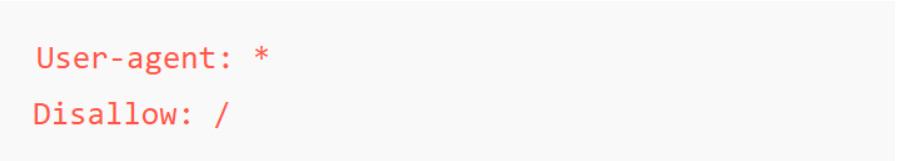

Щоб закрити сайт від індексування повністю, наприклад на етапі створення проєкту, додайте таку команду:

У цьому випадку символ «*» після user-agent означає, що правила, описані в директиві, застосовуються до роботів із різних пошукових систем. А наступна команда вказує на те, що не потрібно повністю індексувати весь сайт.

Якщо потрібно залишити доступ до індексації лише для одного пошуковика, можна додати таку команду:

Роботи це прочитають як заборону індексації для всіх краулерів, крім робота Google.

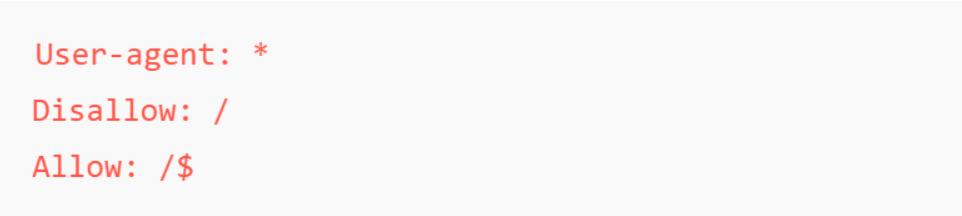

І ще один приклад. Якщо потрібно залишити видимою лише головну сторінку, а решту тимчасово приховати від пошуковика, можна додати такий дозвіл:

На цю команду вказують символи «/$» у директиві аllow. Цей метод застосовується на етапі розробки сайту. По суті, проєкт починає працювати, його розпізнаватимуть та оцінюватимуть алгоритми, але доступ до контенту тимчасово залишається прихованим.

Використовуючи ці директиви в robots.txt, можна гнучко керувати доступом пошукових роботів до сайту залежно від його готовності.

За допомогою метатегу Robots

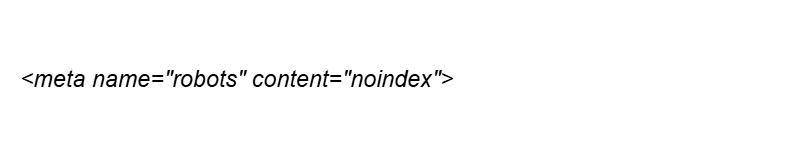

Зверніть увагу: якщо потрібно повністю заборонити індексацію сайту, robots txt — це найбільш релевантний метод. Для роботи на рівні окремих сторінок краще у HTML-коді сторінки додати метатег:

Так ви вкажете пошуковим роботам не індексувати конкретну сторінку.

У цьому випадку використовуються чотири основні команди:

- index / noindex — дозвіл на індексацію сторінки або, відповідно, на заборону цієї дії;

- follow / nofollow — дозвіл або заборона для бота переходити за посиланнями, розміщеними на сторінці.

У наведеному вище прикладі вказано заборону індексації конкретної сторінки.

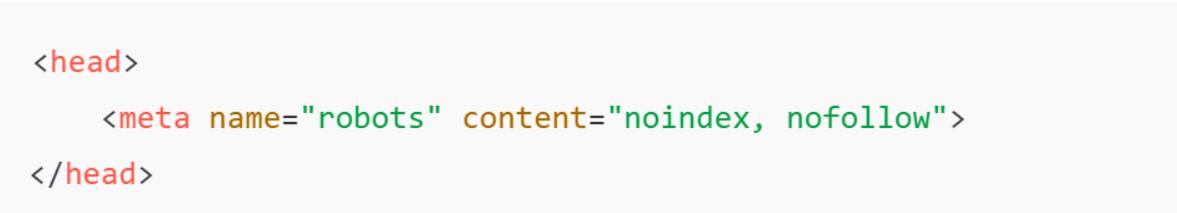

Якщо ви вкажете такі команди, це означатиме, що ви забороняєте не тільки індексувати вміст сторінки, але й переходити за посиланнями.

Заміна robots на, наприклад, bing служить сигналом для заборони додавання до індексу лише однієї конкретної пошукової системи.

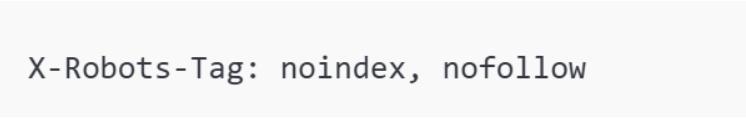

На рівні X-Robots-Tag

Аналогічну команду, що допомагає приховати сайт від пошукових систем, можна задати на рівні сервера.

Цей метод корисний для захисту від індексації зображень, PDF-файлів або іншого контенту, на який не можна додати HTML-метатеги.

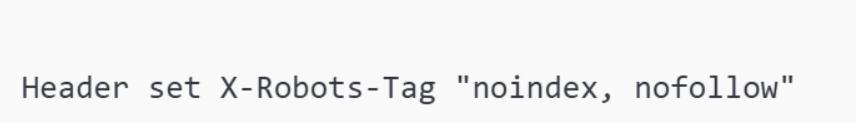

Якщо ви ведете роботи на сервері Apache, додайте до .htaccess таку команду:

Так ви зможете закрити сайт від перегляду, індексації та переходів за посиланнями.

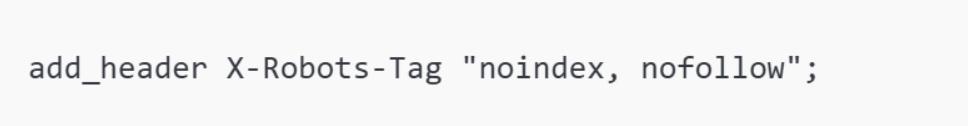

На сервері Nginx використовуйте команду add_header у конфігураційному файлі:

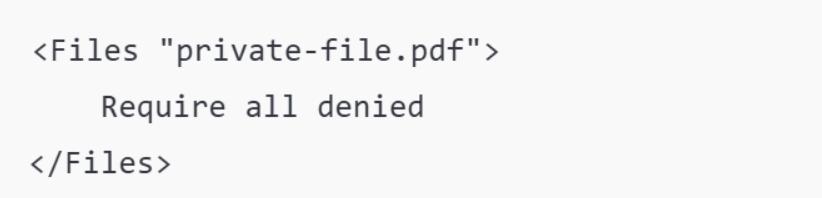

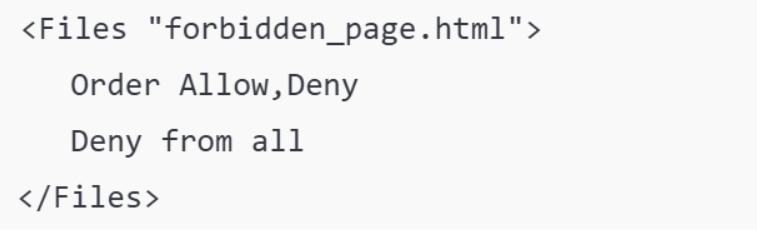

За допомогою HTTP-коду 403 (Forbidden)

HTTP-код відповіді 403 повідомляє пошуковим роботам, що доступ до сторінки заборонено. Це непрямий метод, що дозволяє закрити сайт від пошукових систем.

Для виконання цієї процедури створіть forbidden.html і налаштуйте так, щоб повідомляти користувачів про закритий доступ.

Налаштуйте HTTP-код 403 і файл robots.txt. Додайте команду для надсилання HTTP-коду 403 на сервері, наприклад в .htaccess для Apache:

Також додайте до robots.txt директиву, що забороняє індексацію.

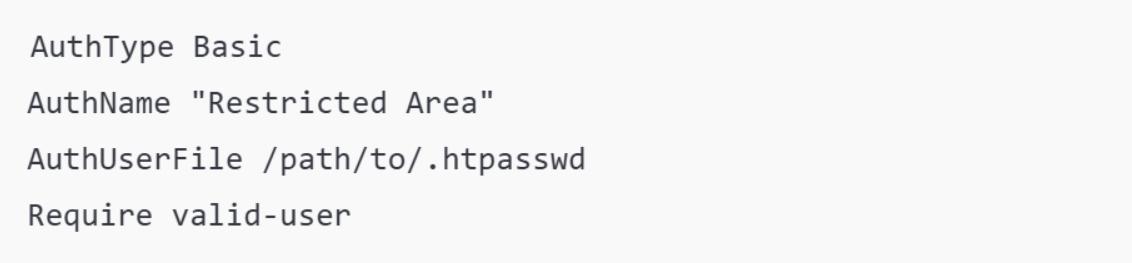

Захист сторінки паролем

Парольний захист — це ще один спосіб обмежити доступ до сторінок, які не повинні індексуватися. Це корисно не тільки для того, щоб вимкнути індексацію сайту або окремих розділів, але й запобігти доступу користувачів до сторінок без знання пароля.

На серверах Apache можна налаштувати парольний захист за допомогою .htpasswd і .htaccess. Для цього створіть файл .htpasswd з паролем.

В .htaccess додайте:

Цей метод зручний для:

- панелей адміністратора;

- тестових версій сайту;

- захисту персональної інформації від публікації.

У поєднанні з директивою disallow у robots.txt це підвищує рівень конфіденційності.

Підбиваючи підсумки

Ви дізналися, як закрити сайт від індексації, а тепер залишається вибрати метод, який буде використано. На етапі створення сайту краще працювати з файлом robots.txt. Для обмеження доступу до окремих сторінок підійде метатег robots або X-Robots-Tag. Якщо потрібно обмежити доступ до важливої інформації, яка не повинна стати загальним надбанням, використовуйте HTTP-код 403 або захист паролем. Контролюйте результати своїх дій і за потреби звертайтеся за допомогою до професіоналів.

FAQ

Як вимкнути сайт від індексації?

Існує кілька методів для цього. Якщо потрібно повністю закрити доступ до вебресурсу, використовуйте файл robots.txt. Додайте до нього команду disallow. Якщо необхідно відключити від індексування окремі сторінки, додайте метатег robots до заголовка сторінки.

Навіщо закривати сайт від індексації?

Рішення заборонити доступ до сайту може бути прийняте на етапі його розробки, а також під час технічних робіт або внесення змін щодо юзабіліті або загального дизайну вебресурсу. Доступ до окремих сторінок закривають, коли виявляється дублювання контенту або потрібно захистити конфіденційну інформацію.

Навіщо закривати посилання від індексації?

Буває, що сторінка, на яку веде посилання, фактично вже не існує або видалена, але інформація може індексуватися пошуковими системами. У таких випадках необхідно закрити сторінку від індексації й оновити картку сайту, щоб виправити помилку. Цей метод застосовується також для захисту від дублювання контенту або закриття доступу до неактуальної інформації.

Залишіть ваші контактні дані.

Будемо раді обговорити ваш проект!